Introduction : comment distinguer l'IA de ChatGPT

# Plan

- Présentation de la série d’atelier

- Qu’est-ce que l’IA ?

- Intérêt d’étudier l’IA pour les SHS

- Retours historiques

- Typologie des IA

- Cas d’usage et modélisation experte (ELIZA)

- Cas d’usage et modélisation distributionnelle/vectorielle (vectorisation et prédiction)

- Les LLMs

- Usages des LLMs hors chatbots (demo)

- LLMs et chatbots (Duck.ai + Ollama)

- Conclusions

# Présentation et objectif des ateliers

Format : 4 séances de 2heures, sans inscription, participation libre (à justifier pour le certificat des Humanités Numériques)

Théorie et pratique en alternance au cours des deux heures.

Objectifs de la série d’atelier :

- Comprendre les fondamentaux de l’IA et son histoire

- Obtenir des notions critiques sur le fonctionnement profond des outils

- Tester et s’approprier des outils d’IA

- Maîtriser le vocabulaire de la discipline

Objectifs de cet atelier :

- Comprendre les différentes formes d’IA

- Comprendre les enjeux liés à l’utilisation des LLM

- Tester différents paramètres d’IA générative.

- Installer localement des modèles de langue.

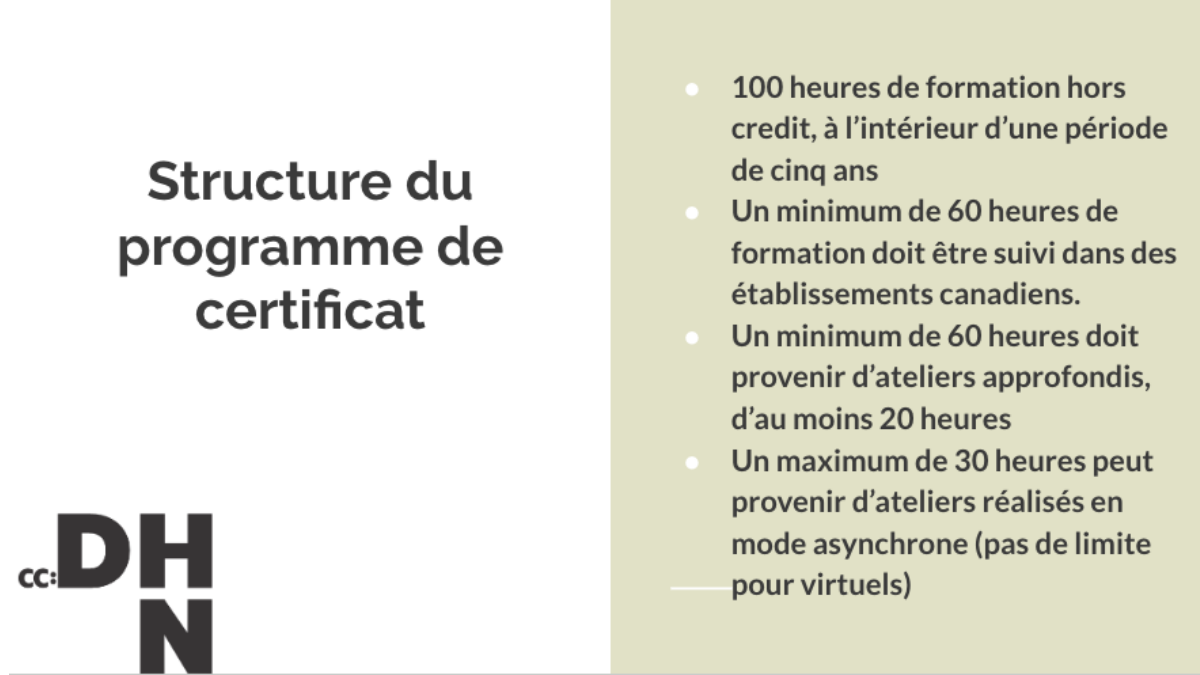

# Certificat canadien en Humanités Numériques

Certificat canadien en Humanités Numériques

# Qu’est ce que l’IA ?

-

Tout et rien : exemples : chatbot, détection sur des imageries médicales, HTR, DeepBlue.

-

le dernier mot à la mode. Le ’numérique’ des années 2020. (Citation: Vitali-Rosati, 2025) Vitali-Rosati, M. (2025). Manifeste pour des Études Critiques de l’Intelligence Artificielle. Consulté à l’adresse http://blog.sens-public.org/marcellovitalirosati/manifeste-ecia.html .

Définition pratique : « un programme informatique qui effectue une prédiction. »

À quoi sert d’étudier l’IA pour les chercheur.se.s en SHS

# L’IA et les SHS

Que peuvent faire les SHS pour l’IA ?

- participer à la réflexion actuelle sur son utilisation :

- positionnements de revues et de conférences (pose un cadre, parfois un précédent)

- proposer une théorie critique de l’IA décentrées de l’effet ‘benchmarking’ (i.e. comparaison des modèles ou des entreprises qui les mettent à disposition)

- proposer une avis sur l’utilisation de ces outils qui soit propre à sa discipline (ex: distinguer des usages en fonction des besoins particuliers de son domaine).

# Exemples de prises de position

Both SUP and JHUP have increasingly embraced, tested, and deployed some AI tools and policies. Barbara has been clear in her support of responsible uses of AI and the necessity of leveraging these early days to stake a claim within the quickly evolving landscape. Like SUP, JHUP is building and testing its own tools for marketing, accessibility, and analytics, efforts which place our presses in a position to potentially build services that might in the future even benefit other university presses. (Citation: Mulliken, 2025) Mulliken, J. (2025). 2025 AUPresses Week-in-Residence Report. Consulté à l’adresse https://digitaldigest.up.hcommons.org/2025/07/09/2025-aupresses-week-in-residence-report-jasmine-mulliken/

we offer recommendations for citing generative AI, defined as a tool that « can analyze or summarize content from a huge set of information, including web pages, books and other writing available on the internet, and use that data to create original new content » (Weed). (Citation: S.A., 2023) (S.A.). (2023). How do I cite generative AI in MLA style?. Consulté à l’adresse https://style.mla.org/citing-generative-ai/

The uncomfortable truth for researchers and publishers who oppose AI slowly taking over human review is that they might not be able to prevent it. Should a researcher use AI to write the first pass of peer review and not disclose it — in contravention of publisher guidelines — that might not be detectable, says Hosseini, who is also one of the editors of the journal Accountability in Research. And if AI reviews become widespread, that could change the practice of science, says Priem. « Every researcher can run their own bespoke review service over the preprint/dataset landscape, flagging/extracting only the science they care about (at any « quality » level) they want that day, » he wrote on X earlier this year. That could start to eat into the roles of journals, by taking away the certification that peer review mediated by journals provides, he says. (Citation: Naddaf, 2025) Naddaf, M. (2025). AI is transforming peer review — and many scientists are worried. Nature, 639(8056). 852–854. https://doi.org/10.1038/d41586-025-00894-7

Building critical AI literacies is a process of empowerment that enables students and citizens to exercise independent judgment about whether or if to use this very new and largely untested commercial technology. (Citation: S.A., 2024) (S.A.).(2024, 7/9). Consulté à l’adresse https://docs.google.com/document/u/0/d/e/2PACX-1vQyyR4MbzQyqTrUgJ_l2wKp-EiKsRHYutmcdCPJxoGPhmagRNoN2tS9f4LP37hWhSe2nZcAjRqtSTiY/pub?pli=1

# Brève histoire de l’IA (pt. 1)

(1940s : Science-fiction et roman d’Isaac Asimov Runaround en 1942.)

(Citation: Turing, 1950) Turing, A. (1950). Computing Machinery and Intelligence. Mind, LIX(236). 433–460. https://doi.org/10.1093/mind/LIX.236.433 : ‘can machines think?’

1956: ‘intelligence artificielle’, Minsky et McCarthy à la Dartmouth Summer Research Project on Artificial Intelligence (DSRPAI).

1966 : ELIZA (Citation: Weizenbaum, 1966) Weizenbaum, J. (1966). ELIZA— a computer program for the study of natural language communication between man and machine. Communications of the ACM, 9(1). 36–45. https://doi.org/10.1145/365153.365168

1990-2000s : pic des systèmes experts et des arbres de décision. DeepBlue d’IBM (Citation: Campbell & al., 2002) Campbell, M., Hoane, A. & Hsu, F. (2002). Deep Blue. Artificial Intelligence, 134(1). 57–83. https://doi.org/10.1016/S0004-3702(01)00129-1 .

# Brève histoire de l’IA (pt. 2)

2010s : pic des systèmes d’IA avec une modélisation distributionnelle du language (vecteur). Word2Vec (Citation: Mikolov & al., 2013) Mikolov, T., Chen, K., Corrado, G. & Dean, J. (2013). Efficient Estimation of Word Representations in Vector Space. https://doi.org/10.48550/arXiv.1301.3781 , GloVE (Citation: Pennington & al., 2014) Pennington, J., Socher, R. & Manning, C. (2014). GloVe: Global Vectors for Word Representation. Association for Computational Linguistics. https://doi.org/10.3115/v1/D14-1162 . Parmi les avancées majeures de cette modélisation on compte le mécanisme d’attention (Citation: Vaswani & al., 2017) Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A., Kaiser, L. & Polosukhin, I. (2017). Attention Is All You Need. https://doi.org/10.48550/arXiv.1706.03762 et l’encodage bidirectionnel BERT (Citation: Devlin & al., 2019) Devlin, J., Chang, M., Lee, K. & Toutanova, K. (2019). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. Association for Computational Linguistics. https://doi.org/10.18653/v1/N19-1423 qui permettent des modèles très performants comme le GPT-3 d’OpenAI (Citation: Brown & al., 2020) Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P., Neelakantan, A., Shyam, P., Sastry, G., Askell, A., Agarwal, S., Herbert-Voss, A., Krueger, G., Henighan, T., Child, R., Ramesh, A., Ziegler, D., Wu, J., Winter, C., Hesse, C., Chen, M., Sigler, E., Litwin, M., Gray, S., Chess, B., Clark, J., Berner, C., McCandlish, S., Radford, A., Sutskever, I. & Amodei, D. (2020). Language Models are Few-Shot Learners. https://doi.org/10.48550/arXiv.2005.14165 .

Actuellement : tendance à l’hybridation de ces modèles : Neuro-Symbolic Integration, Semantic Web Machine Learning (Citation: Marcus, 2020) Marcus, G. (2020). The Next Decade in AI: Four Steps Towards Robust Artificial Intelligence. https://doi.org/10.48550/arXiv.2002.06177 , (Citation: Kautz, 2022) Kautz, H. (2022). The third AI summer: AAAI Robert S. Engelmore Memorial Lecture. AI Magazine, 43(1). 105–125. https://doi.org/10.1002/aaai.12036 , (Citation: Russell & al., 2022) Russell, S. & Norvig, P. (2022). Artificial intelligence: a modern approach (Fourth edition, global edition). Pearson.

# Typologie de l’IA

-

Approche experte ou modèle symbolique : modélisation d’un programme à partir de règles précises. Les règles doivent être applicables à de nouvelles données pour faire une prédiction.

-

Approche inductive ou modèle d’apprentissage machine (machine learning) : modélisation d’un programme à partir d’un grand volume de données. Ce sont les motifs de répétitions qui permettent à la machine d’émettre une prédiction.

# Ce qu’il faut retenir

- L’IA réfère à plusieurs type de modélisations pour la prédiction : une approche déductive et une approche inductive.

- On parle ‘des saisons’ de l’IA pour évoquer l’attrait public de la discipline et son avancée depuis les années 1950.

- Par conséquent, certaines approches attirent l’attention à un moment donné, actuellement IA = chatbot voire ChatGPT.

- L’IA réfère à des algorithmes qui permettent d’automatiser une prise de décision et pas seulement à des programmes de génération textuelle.

# Partons d’un exemple

Objectif : obtenir un programme capable de classer une phrase selon une thématique prédéfinie.

Exemple : Classification d’un texte soit en « parle de fruit » soit en « ne parle pas de fruit ».

# Modéliser une approche experte

- faire appel à un expert : un humain pour déterminer les règles qui définissent ce qui est une phrase parlant de fruits.

- exemple de règle possible : liste de mots comme ‘pomme, pommes, banane, poire etc.’ ordre des mots ou POS pour distinguer ‘orange’ couleur du fruit par exemple.

Une approche qui sembler simpliste en apparence mais qui :

- peut s’avérer très complexe (ex: traduction)

- est la base de systèmes très performants

- entre dans une logique de lazy computing (Citation: Fujinaga, 2025) Fujinaga, I. (2025). On the virtues of lazy machines. Consulté à l’adresse https://crihn.openum.ca/nouvelles/2025/06/02/video-de-la-conference-pleniere-de-ich-fujinaga-dhsi-2025-institute/

- révèle les tâches de bas niveau pour passer d’une chaîne de caractères à un ensemble de caractéristiques : tokenisation, POS-tagging.

# Exemple d’un programme conversationnel /génération textuelle avec une approche experte ELIZA

Try it yourself : ELIZA

Eliza is a pattern-matching automated psychiatrist. Given a set of rules in the form of input/output patterns, Eliza will attempt to recognize user input phrases and generate relevant psychobabble responses. Each rule is specified by an input pattern and a list of output patterns. A pattern is a sentence consisting of space-separated words and variables. (Citation: Connelly) Connelly, D. (s.d.). Consulté à l’adresse https://dhconnelly.com/paip-python/docs/paip/eliza.html

Exemple de literate programming (Citation: Knuth, 1984) Knuth, D. (1984). Literate Programming. The Computer Journal, 27(2). 97–111. https://doi.org/10.1093/comjnl/27.2.97 :

# Approche inductive : le machine learning classique

# 1e étape Modélisation des données

- Constitution d’un corpus : obtenir un ensemble important de documents

- Annotation : attribution d’une classe à chaque document par un humain/expert, ground truth ou vérité de terrain.

- Encodage vectoriel : Comptage des tokens dans l’ensemble du jeu de données et dans chaque phrase/document.

- On obtient une représentation vectorielle = coordonnées dans un espace vectoriel à n dimensions.

# 2e étape Choix de l’algorithme de classification

Différentes logiques permettent de distinguer les données entre elles. Quelques exemples d’apprentissage machine classique :

- K-Nearest Neighbor -> le token apartient à la même classe que ses voisins (au nombre K)

- Arbre de décision -> on construit un arbre de questions fermées qui dessine le jeu de données.

- Regression logistique -> une ligne sépare l’espace vectoriel entre les deux classes

# 3e étape Entraînement supervisé : apprentissage spécialisé

Ajustement des poids (valeurs des vecteurs) à partir de données spécialisées

# Approche inductive généraliste : les LLMs

Exemple de LLMs : BERT, GPT-4, Mixtral, Gemini, Llama, Qwen, DeepSeek etc.

# Foundational models : Pré-entrainement

Constitution d’un corpus non annoté

Apprentissage auto-supervisé : le modèle apprend à prédire le mot suivant ou remplir un blanc dans une phrase.

Encodage itératif : chaque mot/token est encodé en vecteur (embeddings) et le réseau ajuste ses poids en fonction du contexte.

Dès cette étape on obtient un modèle généraliste capable de faire des prédictions à partir d’une requête en langue naturelle.

# Fine-tuning affinage.

Spécialisation du modèle sur une tâche précise à partir d’un jeu de données annotées.

# Alignement

Instruction-tuning : entraînement supervisé sur des données « question → réponse ».

Reinforcement Learning with Human Feedback : des annotateurs évaluent les sorties du modèle, et un apprentissage par renforcement ajuste les préférences du modèle.

# En résumé

Modèle de langue = modélisation de la langue dans son ensemble + capacité de prédiction.

Les LLMs font de la prédiction de token :

- la génération de texte n’est pas la première ni la seule utilisation des LLMs.

- soliciter un LLM pour générer un texte demande de recalculer le token le plus probable à chaque token -> coût énergétique important.

# LLMs et chatbot

Parce que les LLMs sont lourds (plusieurs Gigas) et parce qu’il est coûteux en énergie d’effectuer les calculs qui permettent de déterminer le prochain token (plusieurs GPU), l’usage le plus courant des IA générative est via le site propriétaire qui va interroger le modèle sur un serveur distant. C’est la forme ChatGPT, Mistral.ai, etc.

# Duck.ai

duck.ai permet de comparer des modèles en interfaces chat tout en conservant des données privées.

# Circuit Tracing

Interprétation du méchanisme par lequel un modèle effectue produit une prédiction à partir d’un prompt.

Neuronpedia ‘circuit tracing’ demo : Explication du processus interne d’un LLM pour la prédiction d’un token à partir d’un prompt.

(Citation: Ameisen & al., 2025) Ameisen, A., Lindsey, J., Pearce, A., Gurnee, W., Turner, N., Chen, B., Citro, C., Abrahams, D., Carter, S., Hosmer, B., Marcus, J., Sklar, M., Templeton, A., Bricken, T., McDougall◊, C., Cunningham, H., Henighan, T., Jermyn, A., Jones, A., Persic, A., Qi, Z., Thompson, T., Zimmerman, S., Rivoire, K., Conerly, T., Olah, C. & March 27, J.(2025, 3/27). Consulté à l’adresse https://transformer-circuits.pub/2025/attribution-graphs/methods.html# Ollama

Il est possible de faire tourner un SLM (small language model) localement. Pour ce faire : ollama est une bibliothèque qui permet de télécharger et d’utiliser localement un LLMs.

# Installation et utilisation de Ollama

# Utilisation de Ollama en invite de commande

Via l’invite de commande

ollama run llama3.2 -> télécharge et lance le modèle.

""" -> pour des instructions longues

/show info -> information sur le modèle téléchargé

ollama list -> liste des modèles téléchargés et utilisables

ollama rm llama3.2 -> supprime un modèle

# Paramètres d’un modèle

- Le seed (nombre que l’on peut choisir): les LLMs ont une variable aléatoire au moment de l’encodage des données et au moment du requêtage : le seed permet d’utiliser toujours le même ordre aléatoire, càd d’obtenir pour un même prompt toujours la même réponse. Enjeu de reproductibilité.

- La température (valeur de 0 à 1): détermine le degré d’utilisation de la variable aléatoire. Une température élevée signifie que le modèle sera plus « créatif » car il donnera plus probablement un token qui a une probabilité absolue moindre dans son contexte.

- top_k (valeur de 0 à 100): variable qui réduit la probabilité de générer des tokens absurdes. Une valeur élevée donne des réponses plus variées et une valeur basse des réponses plus conservatrices. (Défaut 40)

- top_p (valeur de 0 à 1): Fonctionne avec le top_k. Une valeur haute donne un texte varié, une valeur basse, un texte conservateur. (Défaut: 0,9)

Source : Documentation Ollama

# Model Steering ou System message

Reconduire un modèle consiste à lui fournir des ordres qui vont modifier son comportement pour toutes les interactions suivantes : cette instruction initiale est le « System message ».

Steer model interactively on Neuronpedia

Créer un nouveau document ‘Modelfile’ sans extension.

Linux : cat > Modelfile puis CTRL+C :

FROM llama3.2 PARAMETER temperature 1 top_k 100 top_p 1 seed 17 SYSTEM « Tu es un chien »

puis CTRL+SHIFT+D et CTRL+D

Windows cmd (Win+R): echo 'FROM llama3.2 PARAMETER temperature 1 top_k 100 top_p 1 seed 17 SYSTEM "Tu es un chien"' > Modelfile (CTRL+SHIFT+D)

Ou c/c manuellement :

FROM llama3.2 PARAMETER temperature 1 top_k 100 top_p 1 seed 17 SYSTEM « Tu es un chien »

ollama create chien -f Modelfile

ollama run chien

# Limites des interfaces de chat

- les chatbots ont des limites : on peut ‘hacker un LLM’ avec du prompt injection ou autres techniques de jailbreaking.

Hidden prompts reportedly were discovered in at least 17 academic preprints on arXiv that purportedly instructed AI tools to deliver only positive peer reviews. The lead authors are reportedly affiliated with 14 institutions in eight countries, including Waseda University, KAIST, Peking University, and the University of Washington. The alleged concealed instructions, some of which were reportedly embedded using white text or tiny fonts, were purportedly intended to influence any reviewers who rely on AI tools. (https://incidentdatabase.ai/cite/1135)

- il n’y a pas d’hallucinations, toutes les générations produites par un LLMs ont la même teneur de vérité du point de vue de l’outil : le modèle ne peut pas évaluer sa réponse à l’aune d’un référentiel extérieur.

# Prompt engineering

Rendre un prompt robuste et surtout permettre l’évaluation systématique d’une stratégie de prompt. Réintégrer une forme de modélisation de son problème pour optimiser un prompt : le template.

ChainForge : outil de comparaison de prompt : comparaison de modèle, comparaison de template (un texte qui inclut des variables) visualisation côte à côte des sorties.

# Études critiques de l’IA

Discipline émergente : Critical AI revue lancée en 2023.

Pistes de réflexions :

- Uniformisation des pratiques et des modes de pensées : l’interface de chat est une façon de formaliser son problème, quid de la recherche de solution en interrogeant des moteurs de recherche, des bases de données ou des archives spécialisées ?

- Derrière l’apparente accessibilité de l’interface de chat, est-ce qu’on ne risque pas de creuser l’écart de la littératie numérique ?

- Est-ce que ces connaissances spécifiques, comme celles du code, qui impliquent des capacités de raisonnement alternatives, ne risquent pas de se retrouver suelement dans une forme d’élite intellectuelle ?

- Comment peut-on définir une littéracie propre aux outils d’IA ?

- Quelle posture adopter ? Faut-il interdire l’usage dans la recherche ou l’enseignement, obliger une déclaration d’utilisation/citation ou encore laisser faire selon les usages et opter pour une approche pédagogique ?

# Ce qu’il faut retenir

- L’IA est amalgamé aux LLMs et en particulier aux interfaces de chatbots mais cela recouvre en réalité des processus algorithmiques variés.

- L’histoire de l’IA a montré qu’il y a des phases tant dans les approches valorisées que dans l’approbation de l’‘intelligence artificielle’ opposée à l’intelligence humaine.

- un système expert (symbolique) peut être aussi complexe et ‘intelligent’ qu’un LLM.

- Les systèmes d’IA n’ont pas de connaissance du réel et sont des modèles purement probabilistes.

- Les ‘halllucinations’ ne sont pas des anomalies, ce sont des erreurs que l’on qualifie a postériori comme telles.

- Les systèmes inductifs sont appropriés pour certaines tâches : classification, production de résumé. Leur point fort reste leur adaptabilité à de nouveaux contextes.

- Les chatbots sont des interfaces qui permettent un échange homme-machine en langue naturelle : l’exploitation des capacités inductives d’un LLMs ne nécessite pas de passer par une telle interface. Ex : classification, processus expérimental plus adapté à une utilisation sans cette interface.

# Ressources vues pendant l’atelier

Duck.ai : Comparaison de modèles sous forme de chatbot et paramétrage.

Ollama et documentation : Téléchargement de LLM localement. Possibilité de steer un modèle.

Neuronpedia ‘steer’ demo : Comparaison d’un modèle qui a été ‘redirigé’ ou non.

Neuronpedia ‘circuit tracing’ demo : Explication du processus interne d’un LLM pour la prédiction d’un token à partir d’un prompt.

ChainForge : comparer des

spaCy : Librairie Python spécialisée dans le Traitement Automatique des Langues : implémentation dans un programme de LLM (modèles en français disponibles).

Incident Database AI : Résumé des incidents et controverses relevées dans la presse lié aux IA (en anglais).

Critical AI journal : Revue

# Bibliographie

- (S.A.) (2023)

- (S.A.). (2023). How do I cite generative AI in MLA style?. Consulté à l’adresse https://style.mla.org/citing-generative-ai/

- Ameisen, Lindsey, Pearce, Gurnee, Turner, Chen, Citro, Abrahams, Carter, Hosmer, Marcus, Sklar, Templeton, Bricken, McDougall◊, Cunningham, Henighan, Jermyn, Jones, Persic, Qi, Thompson, Zimmerman, Rivoire, Conerly, Olah & March 27 (2025)

- Ameisen, A., Lindsey, J., Pearce, A., Gurnee, W., Turner, N., Chen, B., Citro, C., Abrahams, D., Carter, S., Hosmer, B., Marcus, J., Sklar, M., Templeton, A., Bricken, T., McDougall◊, C., Cunningham, H., Henighan, T., Jermyn, A., Jones, A., Persic, A., Qi, Z., Thompson, T., Zimmerman, S., Rivoire, K., Conerly, T., Olah, C. & March 27, J.(2025, 3/27). Consulté à l’adresse https://transformer-circuits.pub/2025/attribution-graphs/methods.html

- Brown, Mann, Ryder, Subbiah, Kaplan, Dhariwal, Neelakantan, Shyam, Sastry, Askell, Agarwal, Herbert-Voss, Krueger, Henighan, Child, Ramesh, Ziegler, Wu, Winter, Hesse, Chen, Sigler, Litwin, Gray, Chess, Clark, Berner, McCandlish, Radford, Sutskever & Amodei (2020)

- Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., Dhariwal, P., Neelakantan, A., Shyam, P., Sastry, G., Askell, A., Agarwal, S., Herbert-Voss, A., Krueger, G., Henighan, T., Child, R., Ramesh, A., Ziegler, D., Wu, J., Winter, C., Hesse, C., Chen, M., Sigler, E., Litwin, M., Gray, S., Chess, B., Clark, J., Berner, C., McCandlish, S., Radford, A., Sutskever, I. & Amodei, D. (2020). Language Models are Few-Shot Learners. https://doi.org/10.48550/arXiv.2005.14165

- Campbell, Hoane & Hsu (2002)

- Campbell, M., Hoane, A. & Hsu, F. (2002). Deep Blue. Artificial Intelligence, 134(1). 57–83. https://doi.org/10.1016/S0004-3702(01)00129-1

- Connelly (s.d.)

- Connelly, D. (s.d.). Consulté à l’adresse https://dhconnelly.com/paip-python/docs/paip/eliza.html

- (S.A.) (2024)

- (S.A.).(2024, 7/9). Consulté à l’adresse https://docs.google.com/document/u/0/d/e/2PACX-1vQyyR4MbzQyqTrUgJ_l2wKp-EiKsRHYutmcdCPJxoGPhmagRNoN2tS9f4LP37hWhSe2nZcAjRqtSTiY/pub?pli=1

- Devlin, Chang, Lee & Toutanova (2019)

- Devlin, J., Chang, M., Lee, K. & Toutanova, K. (2019). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. Association for Computational Linguistics. https://doi.org/10.18653/v1/N19-1423

- Fujinaga (2025)

- Fujinaga, I. (2025). On the virtues of lazy machines. Consulté à l’adresse https://crihn.openum.ca/nouvelles/2025/06/02/video-de-la-conference-pleniere-de-ich-fujinaga-dhsi-2025-institute/

- Kautz (2022)

- Kautz, H. (2022). The third AI summer: AAAI Robert S. Engelmore Memorial Lecture. AI Magazine, 43(1). 105–125. https://doi.org/10.1002/aaai.12036

- Knuth (1984)

- Knuth, D. (1984). Literate Programming. The Computer Journal, 27(2). 97–111. https://doi.org/10.1093/comjnl/27.2.97

- Marcus (2020)

- Marcus, G. (2020). The Next Decade in AI: Four Steps Towards Robust Artificial Intelligence. https://doi.org/10.48550/arXiv.2002.06177

- Mikolov, Chen, Corrado & Dean (2013)

- Mikolov, T., Chen, K., Corrado, G. & Dean, J. (2013). Efficient Estimation of Word Representations in Vector Space. https://doi.org/10.48550/arXiv.1301.3781

- Mulliken (2025)

- Mulliken, J. (2025). 2025 AUPresses Week-in-Residence Report. Consulté à l’adresse https://digitaldigest.up.hcommons.org/2025/07/09/2025-aupresses-week-in-residence-report-jasmine-mulliken/

- Naddaf (2025)

- Naddaf, M. (2025). AI is transforming peer review — and many scientists are worried. Nature, 639(8056). 852–854. https://doi.org/10.1038/d41586-025-00894-7

- Pennington, Socher & Manning (2014)

- Pennington, J., Socher, R. & Manning, C. (2014). GloVe: Global Vectors for Word Representation. Association for Computational Linguistics. https://doi.org/10.3115/v1/D14-1162

- Russell & Norvig (2022)

- Russell, S. & Norvig, P. (2022). Artificial intelligence: a modern approach (Fourth edition, global edition). Pearson.

- Turing (1950)

- Turing, A. (1950). Computing Machinery and Intelligence. Mind, LIX(236). 433–460. https://doi.org/10.1093/mind/LIX.236.433

- Vaswani, Shazeer, Parmar, Uszkoreit, Jones, Gomez, Kaiser & Polosukhin (2017)

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A., Kaiser, L. & Polosukhin, I. (2017). Attention Is All You Need. https://doi.org/10.48550/arXiv.1706.03762

- Vitali-Rosati (2025)

- Vitali-Rosati, M. (2025). Manifeste pour des Études Critiques de l’Intelligence Artificielle. Consulté à l’adresse http://blog.sens-public.org/marcellovitalirosati/manifeste-ecia.html

- Weizenbaum (1966)

- Weizenbaum, J. (1966). ELIZA— a computer program for the study of natural language communication between man and machine. Communications of the ACM, 9(1). 36–45. https://doi.org/10.1145/365153.365168